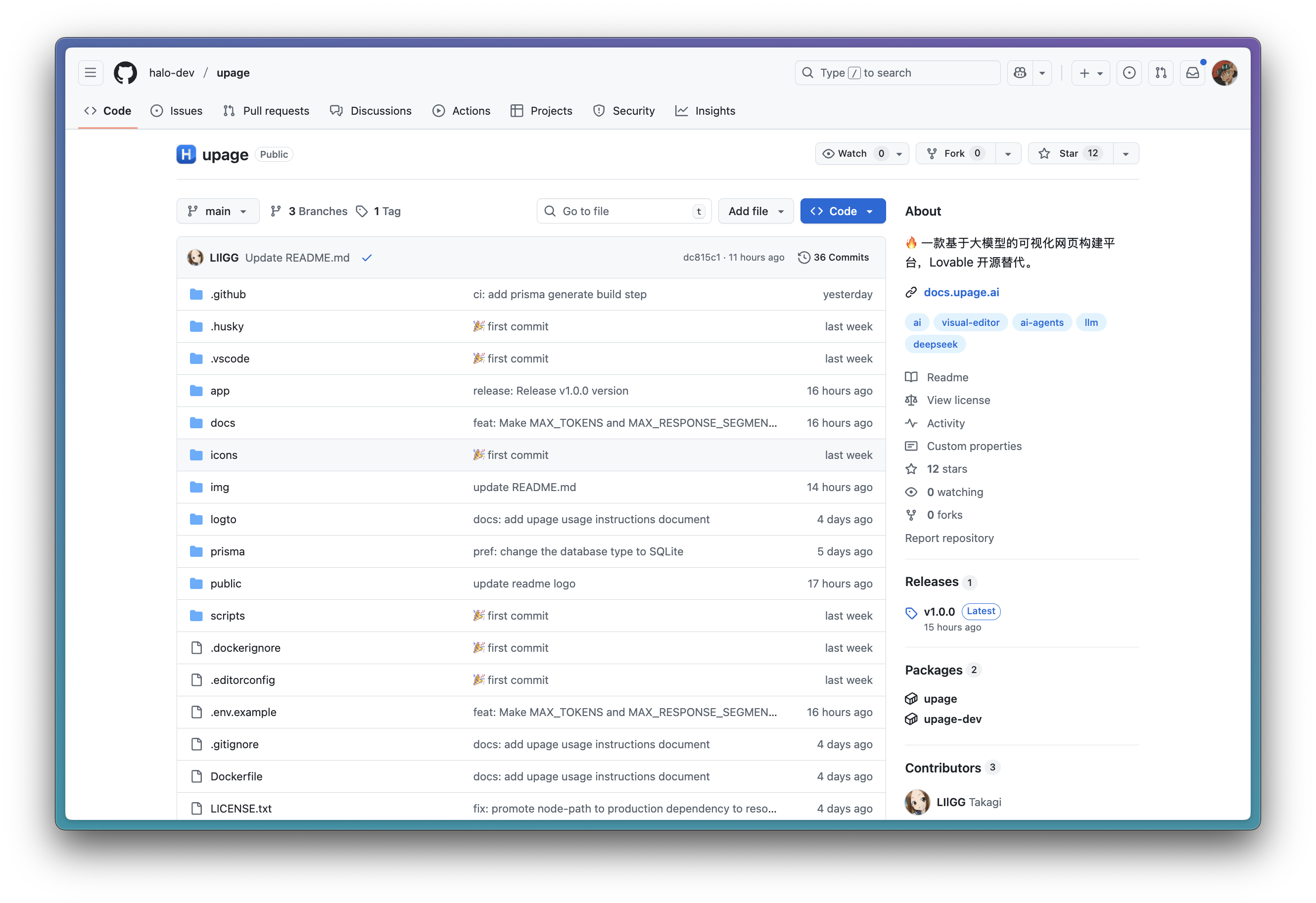

🔥 UPage 正式开源!

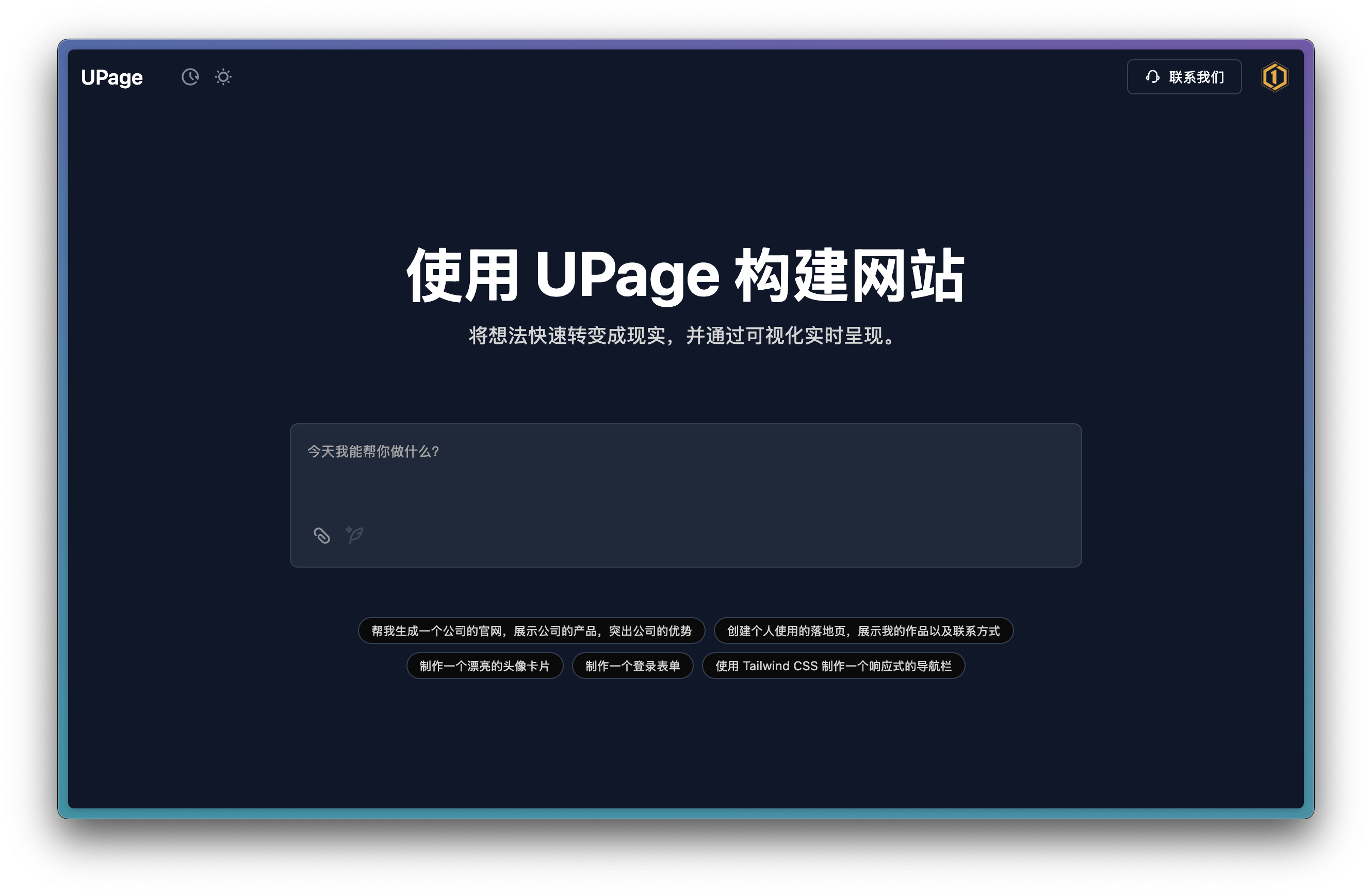

什么是 UPage?

UPage 是一款基于大模型的可视化网页构建平台,支持多种 AI 提供商集成,基于自然语言快速实现定制化网页。它利用大语言模型,让用户能够通过自然语言描述来创建和定制网页。无论您是开发者、设计师还是内容创作者,UPage 都能帮助您快速将想法转化为可视化的网页。

核心特性

- 基于 LLM 的页面生成:通过自然语言描述生成完整的网页

- 多种 LLM 提供商支持:兼容 OpenAI、Anthropic Claude、Google Gemini 等多种 LLM 模型

- 可视化编辑器:简洁直观的可视化编辑器界面,实时预览

- 多页面生成:支持同时生成多个页面

- 代码导出:生成标准的 HTML/CSS/JS 代码,方便集成到现有项目

- 响应式设计:自动适应不同屏幕尺寸

- 部署集成:支持一键部署到常见托管平台

特别感谢 bolt.diy 项目,UPage 的实现基于该项目的代码结构。

许可证

UPage 采用基于 GPL-v3.0 的补充协议许可证。你可以基于 UPage 的源代码进行二次开发,但是需要遵守以下规定:

不能替换和修改 UPage 的 Logo 和版权信息;

二次开发后的衍生作品必须遵守 GPL V3 的开源义务。

快速开始

此快速启动方式仅适用于体验和测试目的,如需在生产环境中完整部署,请参考Docker 部署指南。

前置条件

在开始之前,请确保您的系统满足以下要求:

- Docker 已安装(推荐 Docker 20.10.0 或更高版本)

- 至少 2GB 可用内存

- 至少 2GB 可用磁盘空间

- 互联网连接(用于拉取 Docker 镜像和访问大模型 API)

使用 Docker 快速部署

UPage 提供了官方 Docker 镜像,可以通过以下命令快速启动:

docker run -d \

--name upage \

--restart unless-stopped \

-p 3000:3000 \

-e LLM_PROVIDER=OpenAI \

-e PROVIDER_BASE_URL=your-openai-api-base-url \

-e PROVIDER_API_KEY=your-openai-api-key \

-e LLM_DEFAULT_MODEL=your-default-model \

-e LLM_MINOR_MODEL=your-minor-model \

-v ./data:/app/data \

-v ./logs:/app/logs \

-v ./storage:/app/storage \

halo-dev/upage:latest参数说明

- -e LLM_PROVIDER=OpenAI :设置默认的 LLM 提供商

- -e PROVIDER_BASE_URL=your-openai-api-base-url :设置 API 基础 URL

- -e PROVIDER_API_KEY=your-openai-api-key:设置 API 密钥

- -e LLM_DEFAULT_MODEL=your-default-model:设置用于页面生成的默认 AI 模型

- -e LLM_MINOR_MODEL=your-minor-model:设置用于辅助任务的 AI 模型

- -v ./data:/app/data:挂载数据目录,用于存储数据库文件

- -v ./logs:/app/logs:挂载日志目录

- -v ./storage:/app/storage:挂载存储目录,用于存储上传的文件

访问 UPage

服务启动后,您可以通过浏览器访问:

http://localhost:3000配置 AI 提供商

UPage 支持多种 AI 提供商,您需要至少配置一个 AI 提供商才能使用页面生成功能。以下是常见的 AI 提供商配置示例:

### DeepSeek

-e LLM_PROVIDER=DeepSeek \

-e PROVIDER_API_KEY=your-deepseek-api-key \

-e LLM_DEFAULT_MODEL=deepseek-chat \

-e LLM_MINOR_MODEL=deepseek-reasoner### OpenAI

-e LLM_PROVIDER=OpenAI \

# 此项可选,不填写时,使用 OpenAI 官方 API

-e PROVIDER_BASE_URL=your-openai-api-base-url \

-e PROVIDER_API_KEY=your-openai-api-key \

-e LLM_DEFAULT_MODEL=gpt-4-turbo \

-e LLM_MINOR_MODEL=gpt-3.5-turbo### Anthropic Claude

-e LLM_PROVIDER=Anthropic \

-e PROVIDER_API_KEY=your-anthropic-api-key \

-e LLM_DEFAULT_MODEL=claude-3-opus-20240229 \

-e LLM_MINOR_MODEL=claude-3-haiku-20240307### Ollama

-e LLM_PROVIDER=Ollama \

-e PROVIDER_BASE_URL=http://127.0.0.1:11434 \

-e LLM_DEFAULT_MODEL=llama3 \

-e LLM_MINOR_MODEL=llama3详细的 AI 提供商配置请阅读